Wykład 1: Łańcuchy Markowa w czasie ciągłym

2024-10-03

Piotr Dyszewski

Celem tego rozdziału jest skonstruowanie procesów Markowa w czasie ciągłym na przeliczalnym (lub skończonym) zbiorze \(S\) w oparciu o jego opis infinitezymalny. W następnym rozdziale zbadamy problem konstrukcji dla procesów na bardziej ogólnej przestrzeni stanów. Na razie ograniczamy naszą uwagę do bardziej konkretnej sytuacji przeliczalnego \(S\). W tym przypadku często używa się słowa “łańcuch” zamiast “proces”. clcl

Przypomnijmy, że łańcuchem Markowa w czasie dyskretnym nazywamy proces stochastyczny \(\{X_n\}_{n \in \mathbb{N}}\) takie, że dla dowolnego \(n \in \mathbb{N}\) i dowolnych \(s_0, s_1, \ldots, s_n \in S\) takich, że \[ \mathbb{P}\left[ X_{n-1}=s_{n-1}, \: X_{n-2}=s_{n-2}, \ldots , X_0=s_0 \right]>0 \] zachodzi \[ \mathbb{P}\left[ X_n=s_n \: | \: X_{n-1}=s_{n-1}, \: \ldots , X_0=s_0 \right]= \mathbb{P}\left[ X_n=s_n \: | \: X_{n-1}=s_{n-1} \right]. \] Powyższa własność jest bardzo często przytaczana jako wyjściowa definicja łańcucha Markowa. Mimo swojej prostoty, która ułatwia czytelnikom pierwsze zetknięcie z własnością Markowa, własność ta ma jedną wadę, która ujawnia się przy bardziej zaawansowanych rozważaniach teoretycznych.

Jeżeli chcemy badać tylko procesy na przeliczalnej przestrzeni stanów, to jedno naturalne uogólnienie ma następującą formę. Proces stochastyczny w czasie ciągłym \(\{X(t)\}_{t \in \mathbb{R}_+}\) nazwiemy łańcuchem Markowa w czasie ciągłym na przeliczalnej przestrzeni stanów \(S\), jeżeli dla dowolnego \(n\) i dowolnych \(0 \leq t_0 < t_1 < \ldots < t_n\) i dowolnych \(s_0, s_1, \ldots, s_n \in S\) takich, że \[ \mathbb{P}\left[ X(t_{n-1})=s_{n-1}, \: X(t_{n-2})=s_{n-2}, \ldots , X(t_0)=s_0 \right]>0 \] zachodzi \[\begin{multline*} \mathbb{P}\left[ X(t_n)=s_n \: | \: X(t_{n-1})=s_{n-1}, \: X(t_{n-2})=s_{n-2}, \ldots , X(t_0)=s_0 \right]\\= \mathbb{P}\left[ X(t_n)=s_n \: | \: X(t_{n-1})=s_{n-1} \right]. \end{multline*}\] Powyższa własność nie jest zbyt przydatna, jeżeli chcemy badać procesy na nieprzeliczalnej przestrzeni stanów. Dla bardzo wielu naturalnych obiektów zmienne losowe \(X(t)\) w badanym przez nas procesie mogą mieć rozkład ciągły. Oznacza to, że warunek powyższy nie jest spełniony dla dowolnego wyboru parametrów.

W celu znalezienia bardziej elastycznego warunku zauważmy, że własność Markowa dla jednorodnego łańcucha Markowa \(\{X_n\}_{n \in \mathbb{N}}\) w czasie dyskretnym z macierzą przejścia \[ p(i,j) = \mathbb{P}[X_1=j \: | \: X_0=i] \] zapisuje się jako \[ \mathbb{P}[X_n = j \: | \: \mathcal{F}_n] = p(X_n,j), \] gdzie \(\mathcal{F}_n = \sigma(X_0, X_1, \ldots, X_n)\). Dokładne uzasadnienie powyższej własności pozostawiamy jako zadanie. Podobnie, dla dowolnego \(m \in \mathbb{N}\), \[ \mathbb{P}[X_{n+m} = j \: | \: \mathcal{F}_n] = p^{(m)}(X_n,j), \] gdzie \((p^{(m)(i,j) })_{i, j \in S}\) jest \(m\)-tą potęgą macierzy przejścia \[ p^{(m)}(i,j) = \mathbb{P}[X_m=j \: | \: X_0=i]. \] Oznacza to, że dla dowolnej funkcji mierzalnej \(f \colon S \to \mathbb{R}\), \[ \mathbb{E}[ f(X_{n+m}) \: | \: \mathcal{F}_n] = \sum_{s \in S} f(s) p^{(m)}(X_n, s). \] Powyższa definicja względnie łatwo zapisuje się w czasie ciągłym \[ \mathbb{E}[ f(X_{s+t}) \: | \: \mathcal{F}_s] = \sum_{x\in S} f(x) p^{(t)}(X_n, x), \] gdzie \[ p^{(t)}(y,x) = \mathbb{P}[X_t=x | X_0=y]. \] Relacja powyższa daje się zapisać w przypadku nieprzeliczalnej przestrzeni stanów jako \[\begin{equation*} \mathbb{E}[ f(X_{s+t}) \: | \: \mathcal{F}_s] = \int_S f(x) p^{(t)}(X_n, \mathrm{d} x), \end{equation*}\] gdzie \[\begin{equation*} p^{(t)}(y, \mathrm{d} x) = \mathbb{P}[X_t \in \mathrm{d} x | X_0=y] \end{equation*}\] jest rozkładem \(X_t\) pod warunkiem \(\{X_0=y\}\). To niesie ze sobą kolejne problemy, ponieważ jak wcześniej zauważyliśmy \(\{X_0=y\}\) może być zdarzeniem o prawdopodobieństwie zero. Przedstawione podejście jest do uratowania pod kątem formalnym przez odniesienie się do regularnych rozkładów warunkowych.

Zamiast tego podejdziemy do problemu od innej strony. Naszym punktem wyjścia będzie odpowiednia rodzina miar. Jak zobaczymy wkrótce, to podejście będzie również opierało się o odpowiednik powyższej relacji. Oznacza to, że w rezultacie będziemy opisywali tę samą klasę procesów stochastycznych bez konieczności obchodzenia się z warunkowaniem po zdarzeniach niemożliwych.

Podstawowe definicje

Zaczynamy od prezentacji definicji trzech obiektów, na których się skupimy w tym rozdziale. Przypomnijmy, że będziemy definiować łańcuchy Markowa w czasie ciągłym na dyskretnej przestrzeni stanów \(S\). Topologia na \(S\) to oczywiście topologia dyskretna, względem której wszystkie funkcje są ciągłe.

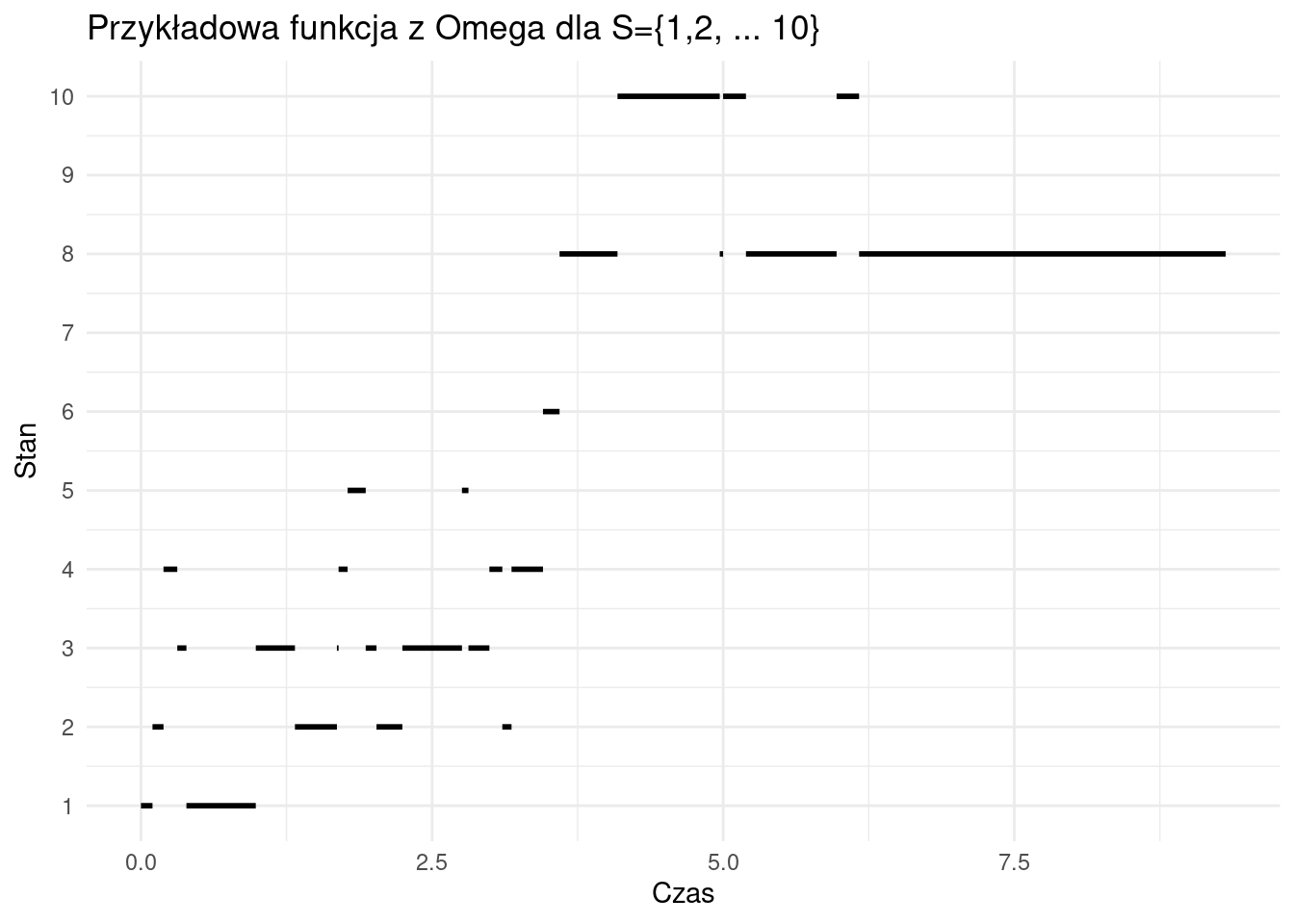

Głównym obiektem naszych badań będą procesy stochastyczne. Ze względów technicznych pracować będziemy na bardzo konkretnej przestrzeni zdarzeń elementarnych. Niech \(\Omega\) będzie zbiorem prawostronnie ciągłych funkcji \(\omega \colon [0, \infty) \to S\) ze skończoną liczbą skoków w dowolnym skończonym przedziale czasowym.

## List of 1

## $ plot.margin: 'margin' num [1:4] 0mm 25mm 0mm 0mm

## ..- attr(*, "unit")= int 7

## - attr(*, "class")= chr [1:2] "theme" "gg"

## - attr(*, "complete")= logi FALSE

## - attr(*, "validate")= logi TRUEDla każdego \(t \in \mathbb{R}_+ = [0, +\infty)\) rozważmy funkcję \(X_t \colon \Omega \to S\) zadaną przez \[ X_t(\omega) = \omega(t). \] Niech \(\sigma\)-ciało \(\mathcal{F}\) na \(\Omega\) będzie najmniejszym takim, że odwzorowanie \(\omega \mapsto \omega(t)\) jest mierzalne dla każdego \(t \in \mathbb{R}_+ = [0, +\infty)\). Niech wreszcie dla \(s \in \mathbb{R}_+\) oznaczmy przez \(\theta_s\) odwzorowanie \(\Omega \to \Omega\) zadane przez \[ \theta_s(\omega)(t) = \omega(t+s). \] W szczególności \(X_t \circ \theta_s = X_{t+s}\). O odwzorowaniu \(\theta_s\) można myśleć jak o przesunięciu czasu o \(s\). Zamiast utożsamiać własność Markowa z procesem stochastycznym \(X=\{X(t)\}_{t \in \mathbb{R}_+}\), utożsamimy ją z rodziną miar probabilistycznych na \(\Omega\), względem której \(X\) będzie procesem Markowa.

Definicja 1 Łańcuchem Markowa w czasie ciągłym na przestrzeni stanów \(S\) nazywamy parę uporządkowaną \(( \mathbf{P}, \mathbb{F})\) taką, że

(ŁM1) \(\mathbb{F}=(\mathcal{F}_t)_{t \in \mathbb{R}_+}\) jest filtracją względem której \(X = (X(t))_{t \in \mathbb{R}_+}\) jest adaptowalny i \(\mathcal{F}_t \subseteq \mathcal{F}\) dla każdego \(t \in \mathbb{R}_+\).

(ŁM2) \(\mathbf{P}= \{ \mathbf{P}_x\}_{x \in S}\). Dla każdego \(x \in S\), \(\mathbf{P}_x\) jest miarą probabilistyczną na \(\Omega\) taką, że \[ \mathbf{P}_x[X_0 = x] = \mathbf{P}_x[\omega \in \Omega : \omega(0)=x]= 1. \]

(ŁM3) Spełniona jest własność Markowa \[ \mathbf{E}_x[Y \circ \theta_s | \mathcal{F}_s] = \mathbf{E}_{X(s)}[Y] \text{ p.n. } \mathbf{P}_x \] dla wszystkich \(x \in S\) i wszystkich ograniczonych mierzalnych \(Y\) na \(\Omega\).

W powyższej definicji \(\mathbf{E}_x\) jest wartością oczekiwaną odpowiadającą mierze probabilistycznej \(\mathbf{P}_x\), czyli \[ \mathbf{E}_x[Y] = \int_\Omega Y(\omega) \: \mathbf{P}_x(\mathrm{d} \omega). \] O zmiennej losowej \(Y \colon \Omega \to \mathbb{R}\) można myśleć jak o statystyce całej trajektorii procesu \(\{X(t)\}_{t \in \mathbb{R}_+}\). Załóżmy, że \(Y\) jest postaci \[ Y(\omega) = f(\omega(t_1), \omega(t_2), \ldots , \omega(t_n)) = f(X(t_1), X(t_2), \ldots, X(t_n)) \] dla pewnej mierzalnej i ograniczonej funkcji \(f \colon \mathbb{R}^n \to \mathbb{R}\) (dla ćwiczenia warto sprawdzić, że \(Y\) powyższej postaci jest istotnie zmienną losową, tj. jest mierzalna względem \(\mathcal{F}\)). Wówczas \[\begin{multline*} Y\circ \theta_s(\omega) = f(\omega(t_1+s), \omega(t_2+s), \ldots , \omega(t_n+s)) \\= f(X(t_1+s), X(t_2+s), \ldots, X(t_n+s)). \end{multline*}\] Własność Markowa w Definicji mówi zatem to, co powinna. Rozkład wektora losowego \((X(t_1+s), X(t_2+s), \ldots, X(t_n+s))\) pod warunkiem \(\mathcal{F}_s\) jest taki sam, jak rozkład wektora \((X'(t_1), X'(t_2), \ldots, X'(t_n))\) dla \(X'=\{X'(t)\}_{t\in \mathbb{R}_+}\) będącym niezależną kopią \(X\), zapoczątkowaną w \(X_0'=X(s)\).

Naszym nadrzędnym celem będzie sprowadzenie powyższej definicji do bardziej przystępnych terminów. Zanim jednak do tego przejdziemy, rozważmy następujący przykład.

Przykład 1 Niech \(N=(N_t)_{t \in \mathbb{R}_+}\) będzie jednorodnym procesem Poissona z intensywnością \(\lambda >0\) określonym na przestrzeni probabilistycznej \((\Sigma, \mathcal{G}, \mathbb{P})\). Przypomnijmy, że oznacza to, że \(t \mapsto N_t\) jest prawostronnie ciągła oraz dla każdego \(t>0\) zmienna losowa \(N_t\) ma rozkład Poissona z parametrem \(\lambda>0\), \[ \mathbb{P}[N_t=k] = e^{-\lambda} \frac{\lambda^k}{k!}, \] i wreszcie dla \(t>s\geq 0\), zmienna \(N_t - N_s\) jest niezależna od \(\sigma\)-ciała \(\mathcal{F}_s^N = \sigma(N_r : r \leq s)\).

Uzasadnimy, że \(N\) jest procesem Markowa w sensie przyjętej przez nas definicji. Przestrzenią stanów jest \(S = \mathbb{N}\). Niech \(\mathbf{P}_x[A] = \mathbb{P}[N + x \in A]\) dla \(A \in \mathcal{F}\). Tutaj \(x+N\) oznacza funkcję \(t \mapsto N_t + x\). Pokażemy teraz, że spełniona jest własność Markowa.

Dla \(A \in \mathcal{F}_s\) mamy \[ \mathbf{E}_x[Y \circ \theta_s \cdot \mathbf{1}_{A}] = \mathbb{E}[Y(N \circ \theta_s + x) \mathbf{1}_{\{N \in A\}}] = \mathbb{E}[Y(N \circ \theta_s - N_s + N_s + x) \mathbf{1}_{\{N \in A\}}]. \] Skoro \(A \in \mathcal{F}_s\), to \(\{N \in A\} \in \mathcal{F}_s^N\) (zadanie). Skoro \(N \circ \theta_s - N_s = (N_{t+s} - N_s)_{t \in \mathbb{R}_+}\) jest niezależny od \(\mathcal{F}_s^N\), to \[ \mathbb{E}[Y(N \circ \theta_s - N_s + N_s + x) \mathbf{1}_{\{N \in A\}} | \mathcal{F}_s] = \mathbf{1}_{\{N \in A\}} \cdot y(N_s + x), \] gdzie \[ y(k) = \mathbb{E}[Y(N \circ \theta_s - N_s + k)] = \mathbf{E}_k[Y]. \] Podsumowując, \[ \mathbf{E}_x[Y \circ \theta_s \cdot \mathbf{1}_{A}] = \mathbb{E}[y(N_s + x) \mathbf{1}_{\{N \in A\}}] = \mathbf{E}_x[y(X(s)) \mathbf{1}_A] \] odwołując się teraz do definicji warunkowej wartości oczekiwanej \[ \mathbf{E}_x[Y \circ \theta_s | \mathcal{F}_s] = y(X(s)) = \mathbf{E}_{X(s)}[Y]. \]

Powyższy przykład pokazuje, że uzasadnienie własności Markowa wprost z definicji nie jest najprostszym zadaniem. Przekonamy się w przyszłości, że taka forma jest przydatna do teoretycznych rozważań. Mimo to przyda się nam bardziej przystępny sposób mówienia o łańcuchach Markowa w czasie ciągłym. Odnosząc się do czasu dyskretnego, korzystać będziemy z funkcji przejścia.

Definicja 2 Funkcją przejścia nazywamy rodzinę odwzorowań \(p = (p_t)_{t \in \mathbb{R}_+}\), gdzie \(p_t \colon S \times S \to [0,1]\) zdefiniowanych dla \(t \ge 0\) takich, że \[ p_t(x, y) \ge 0, \quad \sum_{y \in S} p_t(x, y) = 1, \quad \lim_{t \to 0} p_t(x, x) = p_0(x, x) = 1, \] spełniających równania Chapmana-Kolmogorowa \[ p_{s+t}(x, y) = \sum_{z \in S} p_s(x, z)p_t(z, y). \]

Interpretacją wartości \(p_t(x,y)\) jest prawdopodobieństwo, że w czasie \(t\) proces przejdzie ze stanu \(x\) do stanu \(y\). Innymi słowy, \[ p_t(x,y) = \mathbf{P}_x[X_t = y]. \] Jak się niebawem przekonamy, dzięki własności Markowa pozwala ona jednoznacznie wyznaczyć rozkład procesu, tj. jednoznacznie wyznaczyć miarę \(\mathbf{P}_x\).

Przykład 2 Rozważmy \(S = \mathbb{N}\), \(\lambda > 0\) oraz \(p_t \colon S \times S \to [0,1]\) zadane przez \[ p_t(x, y) = e^{-\lambda t} \frac{(\lambda t)^{y - x}}{(y - x)!} \mathbf{1}_{\{y \geq x\}}. \] Wówczas \(p\) jest funkcją przejścia. Wystarczy zauważyć, że \(p_t(x)\) to prawdopodobieństwo, że zmienna losowa o rozkładzie Poissona z parametrem \(\lambda t\) jest równa \(y - x\). Równania Chapmana-Kołmogorowa wynikają z następującej własności rozkładu Poissona: jeżeli niezależne zmienne losowe \(X\) i \(Y\) mają rozkłady Poissona odpowiednio z parametrami \(\lambda t\) i \(\lambda s\), to \(X + Y\) ma rozkład Poissona z parametrem \(\lambda (t + s)\).

Twierdzenie 1 Dla łańcucha Markowa \((\mathbf{P}, \mathbb{F})\) połóżmy \[ p_t(x, y) = \mathbf{P}_x[X_t = y] \] dla \(t \ge 0\) oraz \(x, y \in S\). Wówczas:

\(p_t(x, y)\) jest funkcją przejścia,

\(p_t(x, y)\) określa miary \(\mathbf{P}_x\) jednoznacznie.

Proof.

- Najpierw pokażemy, że \(\lim_{t \to 0} p_t(x, x) = 1\). Przez prawostronną ciągłość ścieżek, \(\tau = \inf \{ t > 0 : X_t \neq X_0 \} > 0\) \(\mathbf{P}_x\)-p.w. dla dowolnego \(x\) z \(S\). Ponieważ \[p_t(x, x) \ge \mathbf{P}_x[\tau > t] \to 1\] przy \(t \to 0\), to istotnie \(\lim_{t \to 0} p_t(x, x) = 1\).

Równania Chapmana-Kołmogorowa wynikają z własności Markowa. Aby to zobaczyć, rozważmy \(Y = 1_{\{ X(t)=y \}}\). Własność Markowa zapisuje się jako \[ \mathbf{P}_x[X_{s+t} = y | \mathcal{F}_s] = \mathbf{P}_{X(s)}[X_t = y] = p_t(X(s), y) \text{ p.n. } \mathbf{P}_x. \] Biorąc wartości oczekiwane względem \(\mathbf{P}_x\) w tej tożsamości, otrzymujemy równania Chapmana-Kołmogorowa: \[ \mathbf{P}_x[X_{t+s}=y] = \mathbf{E}_x \left[\mathbf{P}_x[X_{s+t} = y | \mathcal{F}_s] \right] = \mathbf{E}_x\left[ p_t(X(s), y) \right] = \sum_{z \in S } p_t(z, y) p_s(x, z). \] To dowodzi a. b. Użyjemy własności Markowa wielokrotnie, aby otrzymać \[ \mathbf{P}_x[X(t_1) = x_1, \ldots, X(t_n) = x_n] = p_{t_1}(x, x_1) p_{t_2 - t_1}(x_1, x_2) \cdots p_{t_n - t_{n-1}}(x_{n-1}, x_n) \] dla \(0 < t_1 < \ldots < t_n\) oraz \(x_1, \ldots, x_n \in S\). Aby to zobaczyć oznaczmy \[ \mathcal{H}_{n-1} = \{ X(t_1) = x_1, \ldots, X(t_{n-1}) = x_{n-1} \} \in \mathcal{F}_{t_{n-1}}. \] Z własności Markowa \[ \mathbf{P}_x[X(t_1) = x_1, \ldots, X(t_n) = x_n | \mathcal{F}_{t_{n-1}}] = \mathbf{P}_x[\mathcal{H}_{n-1}, X(t_n) = x_n | \mathcal{F}_{t_{n-1}}] \] \[ = \mathbf{1}_{\mathcal{H}_{n-1}} \mathbf{P}_x[X(t_n) = x_n | \mathcal{F}_{t_{n-1}}] = \mathbf{1}_{\mathcal{H}_{n-1}} \mathbf{P}_x[X \circ \theta_{t_{n-1}} (t_n - t_{n-1}) = x_n | \mathcal{F}_{t_{n-1}}] \] \[ = \mathbf{1}_{\mathcal{H}_{n-1}} \mathbf{P}_{X(t_{n-1})}[X (t_n - t_{n-1}) = x_n] = \mathbf{1}_{\mathcal{H}_{n-1}} p_{t_n - t_{n-1}}(x_{n-1}, x_n). \] Biorąc wartości oczekiwane, \[ \mathbf{P}_x[X(t_1) = x_1, \ldots, X(t_n) = x_n] = \mathbf{P}_x[\mathcal{H}_{n-1}] p_{t_n - t_{n-1}}(x_{n-1}, x_n). \] Postulowaną równość otrzymujemy przez iterację powyższej procedury. Udowodniona właśnie równość uzasadnia, że funkcja przejścia określa rozkłady skończenie wymiarowe \(\mathbf{P}_x\). Określa również pełną miarę \(\mathbf{P}_x\), ponieważ miary prawdopodobieństwa na \((\Omega, \mathcal{F})\) są określane przez ich skończenie wymiarowe rozkłady w świetle twierdzenia \(\pi - \lambda\). Aby to zobaczyć, załóżmy, że \(\mu\) oraz \(\nu\) to dwie takie miary, które mają te same skończenie wymiarowe rozkłady, i niech \(\mathcal{P}\) będą skończenie wymiarowymi zbiorami w \((\Omega, \mathcal{F})\) oraz \[ \mathcal{L} = \{ A \in \mathcal{F} : \mu(A) = \nu(A) \}. \] Wówczas \(\mathcal{L}\) jest \(\lambda\)-układem zawierającym \(\pi\)-układ \(\mathcal{P}\). Przez twierdzenie \(\pi - \lambda\), \(\sigma(\mathcal{P}) \subseteq \mathcal{L}\). Skoro \(\sigma(\mathcal{P}) = \mathcal{F}\), to \(\mu(A) = \nu(A)\) dla wszystkich \(A \in \mathcal{F}\).

Skoro \(X\) jest elementem \(\Omega\), zbioru funkcji prawostronnie ciągłych o wartościach w przeliczalnym \(S\), to \(X\) jest funkcją kawałkami stałą. W rezultacie do opisu \(X\) wystarczy sprecyzować, w jaki sposób \(X\) zmienia wartość. Opis ten jest dokonywany w kategoriach \(Q\)-macierzy.

Definicja 3 \(Q\)-macierzą nazywamy macierz \((q(x, y))_{x,y \in S}\) liczb rzeczywistych indeksowanych przez \(x, y \in S\), które spełniają \[ q(x, y) \ge 0 \text{ dla } x \neq y \quad \text{oraz} \quad \sum_y q(x, y) = 0. \]

Ponieważ wyrazy diagonalne są niedodatnie i odgrywają specjalną rolę, naturalne jest użycie specjalnego oznaczenia dla nich: \[ c(x) = -q(x, x). \] Przejście od funkcji przejścia do \(Q\)-macierzy jest trudniejsze niż przejście od procesu do funkcji przejścia i wymaga dokonania dodatkowych założeń. Zaczynamy od kilku własności, które obowiązują dla wszystkich funkcji przejścia.

Twierdzenie 2 Załóżmy, że \(p\) jest funkcją przejścia.

Wówczas \(p_t(x, x) > 0\) dla wszystkich \(t \ge 0\) oraz \(x \in S\).

Jeśli \(p_t(x, x) = 1\) dla pewnego \(t > 0\) oraz \(x \in S\), wtedy \(p_t(x, x) = 1\) dla wszystkich \(t > 0\) oraz tego \(x\).

Dla każdego \(x, y \in S\), \(p_t(x, y)\) jest jednostajnie ciągła w \(t\). Dokładniej, \[ |p_t(x, y) - p_s(x, y)| \leq 1 - p_{|t-s|}(x, x). \]

Proof.

Najpierw zauważmy, że \(p_t(x, x) > 0\) dla małych \(t\) zgodnie z przyjętą Definicją 2 Z równań Chapmana-Kołmogorowa, \[ p_{s+t}(x, x) \geq p_s(x, x)p_t(x, x), \] więc ścisła dodatniość rozciąga się na wszystkie \(t\).

Użyjmy równania Chapmana-Kołmogorowa raz jeszcze, aby napisać \[ p_{s+t}(x, x) \leq p_s(x, x)p_t(x, x) + [1 - p_s(x, x)] = 1 - p_s(x, x)[1 - p_t(x, x)]. \] Zatem, jeśli \(p_{s+t}(x, x) = 1\), to \(p_t(x, x) = 1\), ponieważ \(p_s(x, x) > 0\) z części a. Stąd \(\{ t \ge 0 : p_t(x, x) = 1 \}\) jest przedziałem zaczynającym się od 0. Z dowodu części a. wynika, że musi to być cała dodatnia oś.

Ponownie użyjmy równania Chapmana-Kołmogorowa, aby napisać \[ p_{t+s}(x, y) - p_t(x, y) = p_t(x, y)[p_s(x, x) - 1] + \sum_{z \neq x} p_s(x, z)p_t(z, y). \] Pierwszy składnik po prawej stronie jest niedodatni, a drugi jest nieujemny. Wartość bezwzględna każdego z nich nie jest większa niż \(1 - p_s(x, x)\). To pociąga postulowaną nierówność, która z kolei pociąga jednostajną ciągłość.

Twierdzenie 3 Załóżmy, że \(p\) jest funkcją przejścia.

Dla każdego \(x\), prawostronna pochodna \[ c(x) = -q(x, x) = - \left. \frac{\mathrm{d}}{\mathrm{d} t} p_t(x, x) \right|_{t=0} \in [0, \infty] \] istnieje i spełnia \[ p_t(x, x) \ge e^{-c(x)t}. \]

Jeśli \(c(x) < \infty\), wtedy dla tego \(x\) i dla wszystkich \(y \neq x\), prawostronna pochodna \[ q(x, y) = \left. \frac{\mathrm{d}}{\mathrm{d} t} p_t(x, y) \right|_{t=0} \in [0, \infty) \] istnieje oraz \[ \sum_{y \in S} q(x, y) \leq 0. \]

Jeśli dla pewnego \(x \in S\), \(c(x) < \infty\) i \(\sum_y q(x, y) = 0\), to \(p_t(x, y)\) jest różniczkowalna w sposób ciągły względem \(t\) dla tego \(x\) i każdego \(y\), oraz spełnia równania retrospektywne Kołmogorowa: \[ \frac{\mathrm{d}}{\mathrm{d} t} p_t(x, y) = \sum_z q(x, z)p_t(z, y). \]

Proof.

Niech \(f(t) = - \log p_t(x, x)\). Wówczas \(f\) jest dobrze określona i jednostajnie ciągła. Jest ona też subaddytywna. Zatem, zgodnie z Lematem Fekete, \[ c(x) = \lim_{t \to 0} \frac{f(t)}{t} \in [0, \infty] \] i spełnia \(f(t) \leq c(x)t\).

Przypuśćmy, że \(c(x) < \infty\). Z dowiedzionej właśnie nierówności, \[ 1 - p_t(x, x) \leq 1 - e^{-c(x)t} \leq c(x)t, \] i stąd \[ \sum_{y : y \neq x} \frac{p_t(x, y)}{t} \leq c(x). \] Zatem, \[ \limsup_{t \to 0} \frac{p_t(x, y)}{t} < \infty \tag{1} \] dla \(y \neq x\). Niech \(q(x, y)\) będzie wartością powyższej granicy górnej. Aby pokazać, że granica rzeczywiście istnieje, weźmy \(\delta > 0\) i dodatnią liczbę całkowitą \(n\). Macierz \(p_{\delta}(x, y)\) można traktować jako prawdopodobieństwa przejścia dla dyskretnego łańcucha Markowa na \(S\), a wtedy zgodnie z równaniami Chapmana-Kołmogorowa, odpowiadające \(n\)-krokowe prawdopodobieństwa przejścia są dane przez \(p_{n\delta}(x, y)\). Rozkładając zdarzenie, że ten łańcuch znajduje się w \(y\) w czasie \(n\) zgodnie z czasem pierwszej wizyty w \(y\), mamy dla \(y \neq x\), \[ p_{n\delta}(x, y) \geq \sum_{k=0}^{n-1} p_{k\delta}^k(x, x) p_{\delta}(x, y)p_{(n-k-1)\delta}(y, y). \] Stąd \[ \frac{p_{n\delta}(x, y)}{n\delta} \geq \frac{p_{\delta}(x, y)}{\delta} e^{-c(x)n\delta} \inf_{0 \leq s \leq n\delta} p_s(y, y). \] Teraz niech \(\delta \downarrow 0\) wzdłuż ciągu realizującego granicę górną w (1), tak że \[ \frac{p_{\delta}(x, y)}{\delta} \to q(x, y). \] Wybierzmy teraz \(n \to \infty\) tak, że \(n\delta \to t\). Wówczas \[ \frac{p_t(x, y)}{t} \geq q(x, y)e^{-c(x)t} \inf_{0 \leq s \leq t} p_s(y, y) \] dla \(t > 0\). Zatem, \[ \liminf_{t \to 0} \frac{p_t(x, y)}{t} \geq q(x, y). \] Postulowana nierówność wynika teraz z lematu Fatou.

Napiszmy \[ \frac{p_{t+s}(x, y) - p_t(x, y)}{s} = \sum_z \left[ \frac{p_s(x, z) - p_0(x, z)}{s} - q(x, z) \right] p_t(z, y). \] Każdy wyraz w sumie dąży do \(0\), gdy \(s \downarrow 0\), zgodnie z pierwszymi dwoma częściami twierdzenia. Zatem musimy kontrolować ogony sumy. Weźmy skończony zbiór \(T \subset S\) zawierający \(x\) i zauważmy, że \[ \sum_{z \notin T} \left| \frac{p_s(x, z)}{s} - q(x, z) \right| p_t(z, y) \leq \sum_{z \notin T} \frac{p_s(x, z)}{s} + \sum_{z \notin T} q(x, z) \] \[ = s^{-1} \left[ 1 - \sum_{z \in T} p_s(x, z) \right] - \sum_{z \in T} q(x, z) \to -2 \sum_{z \in T} q(x, z) \] gdy \(s \downarrow 0\). Granicę po prawej stronie można uczynić dowolnie małą, wybierając \(T\) duże, ponieważ \(\sum_z q(x, z) = 0\). Zatem prawa strona dąży do zera, gdy \(s \downarrow 0\). To dowodzi, że prawostronne pochodne \(p_t(x, y)\) istnieją i spełniają zadaną równość. Aby zobaczyć, że obustronne pochodne rzeczywiście istnieją, wystarczy zauważyć, że prawa strona jest ciągła w \(t\) i użyć faktu, że funkcja ciągła z ciągłą prawostronną pochodną jest różniczkowalna.